TRADUCIR PRESTASHOP

TRADUCIR PRESTASHOP

Traducir una tienda Prestashop es todo un reto. Tendrás que decidir entre descargar un paquete de localización...

IBIDEM BLOG

Somos traductores profesionales expertos en traducciones jurídicas, traducciones financieras y traducciones técnicas. Traducciones que exigen algo más, un extra de complejidad a nivel DTP, dificultad terminológica, calidad estilística... El problema es que nadie nace aprendido, y todo esto no se enseña en la universidad.

A lo largo de más de 20 años de profesión nos ha tocado aprender de todo, no sólo terminología jurídica, financiera y técnica, también edición gráfica, maquetación, archivos de código, regex, etc. Este blog de traducción recopila todo nuestro saber en unas prácticas Guías profesionales de traducción. Esperamos que os resulten útiles!

Traducir una tienda Prestashop es todo un reto. Tendrás que decidir entre descargar un paquete de localización...

El ranking de las mejores empresas de traducción en España depende de los criterios, necesidades y preferencias de...

¿Es Madrid un buen lugar para estudiar traducción? Te contamos qué universidades y masters de traducción hay en...

Te explicamos cómo se traducen las cuentas anuales de empresa, cuándo hay que traducir cuentas anuales mediante...

El precio de una Traducción Jurada depende de muchos factores. El Traductor Jurado cobra una tarifa de entre 0,15€ y...

Una Traducción Jurada es una traducción de carácter oficial, realizada por un Traductor Jurado autorizado por las...

El Traductor Jurado es un profesional habilitado para realizar traducciones juradas con carácter oficial. En España...

¿Dónde estudiar traducción en Barcelona? ¿Es mejor la UPF (Universidad Pompeu Fabra) o la UAB (Universidad...

Descubre cuáles son las asociaciones de traductores más importantes en España: AATI, ACEC, ACE, AGPTI, AICE, APTIC,...

Presentar las Cuentas Anuales en el Registro Mercantil de otro países no siempre es fácil. Averigua cómo funcionan y...

Descubre qué empresas necesitan traducir unas cuentas anuales. Averigua en qué situaciones una empresa debe...

Consulta y descarga aquí las últimas Cuentas Anuales Consolidadas de todas las empresas del IBEX 35: Balances, Cuenta...

Aprende cómo buscar las Cuentas Anuales de una empresa, y cómo pedirlas al Registro Mercantil. Toda la información...

Resolvemos todas las dudas sobre la presentación de cuentas anuales en el Registro Mercantil. ¿Dónde se presentan...

Presentar cuentas anuales es una pesadilla, pero muchas empresas pueden presentar cuentas anuales abreviadas en lugar...

Apréndelo todo sobre cuentas anuales y estados financieros (no son lo mismo!). Te explicamos en detalle qué son las...

Traducir un eCommerce multiplicará tus ventas: es una inversión fácil y muy rentable. Pero la traducción debe...

Shopify se ha convertido muy rápido en una de las tiendas online más populares. Un año más, en 2024 Shopify es la...

Descubre los mejores traductores online para traducir un texto a otro idioma. Traductores gratuitos online que te...

Descubre WPML ¿Es realmente el mejor plugin de traducción de Wordpress? ¿Cuánto cuesta WPML? ¿Cómo funciona?...

Guía completa para traducir webs Wordpress de forma profesional. Actualizada 2022. Aprende a traducir tu WordPress....

Contar las palabras de una web es clave para saber cuánto costará traducirla. Descubre aquí 5 opciones para...

Antes de traducir los textos de una tienda WooCommerce, debes conocer bien WordPress y saber cómo hacerlo...

Traducir una eCommerce Magento requiere conocer bien el entorno de esta suite de Adobe: saber configurar la traducción...

Guía definitiva para traducir de forma profesional,y paso a paso, una web corporativa, un Wordpress. o un eCommerce....

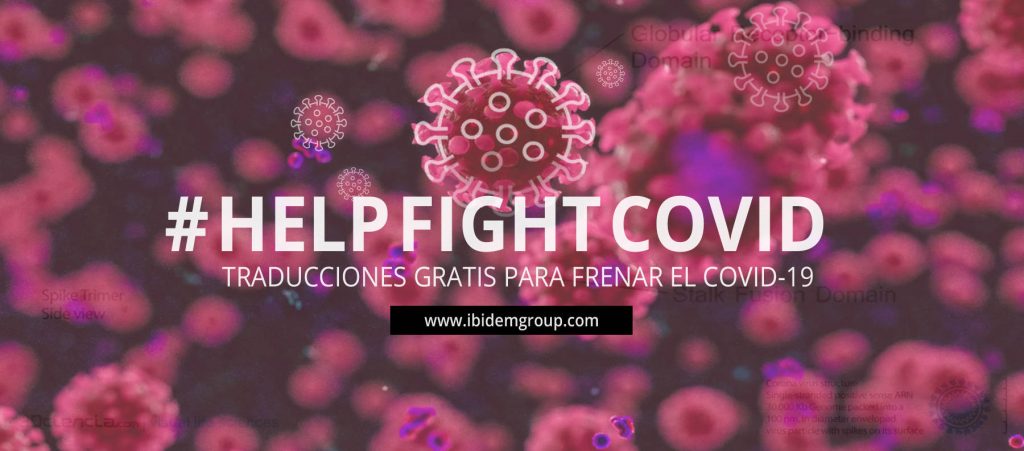

Ibidem Group se suma a las iniciativas solidarias de otras empresas en su lucha contra el Covid-19, ofreciendo...

El precio de traducir una web depende del idioma y del número de palabras, pero también pueden influir otros factores...

10 consejos esenciales que debes plantearte antes de traducir una web, para no caer en los errores más habituales....

Averigua cómo traducir una web lo más barato posible sin recurrir a Google Translate. Trucos para traducir tu web de...

Traducir un archivo XML es posiblemente uno de los retos más técnicos a los que se puede enfrentar un traductor...

AGENCIA TRADUCCIÓN BARCELONA

AGENCIA TRADUCCIÓN BARCELONA

ESTUDIAR TRADUCCION MADRID

ESTUDIAR TRADUCCION MADRID

COMO TRADUCIR CUENTAS ANUALES

COMO TRADUCIR CUENTAS ANUALES

PRECIO TRADUCCIÓN JURADA

PRECIO TRADUCCIÓN JURADA

TRADUCCIÓN JURADA

TRADUCCIÓN JURADA

TRADUCTOR JURADO

TRADUCTOR JURADO

ESTUDIAR TRADUCCION BARCELONA

ESTUDIAR TRADUCCION BARCELONA

ASOCIACIONES DE TRADUCTORES

ASOCIACIONES DE TRADUCTORES

REGISTROS MERCANTILES EXTRANJERO

REGISTROS MERCANTILES EXTRANJERO

CUANDO TRADUCIR CUENTAS ANUALES

CUANDO TRADUCIR CUENTAS ANUALES

CUENTAS ANUALES: EMPRESAS ESPAÑA

CUENTAS ANUALES: EMPRESAS ESPAÑA

PEDIR CUENTAS ANUALES

PEDIR CUENTAS ANUALES

DEPÓSITO DE CUENTAS ANUALES

DEPÓSITO DE CUENTAS ANUALES

CUENTAS ANUALES ABREVIADAS

CUENTAS ANUALES ABREVIADAS

CUENTAS ANUALES: DOCUMENTOS

CUENTAS ANUALES: DOCUMENTOS

TRADUCIR eCOMMERCE

TRADUCIR eCOMMERCE

TRADUCIR SHOPIFY

TRADUCIR SHOPIFY

TRADUCTORES ONLINE

TRADUCTORES ONLINE

WPML WORDPRESS

WPML WORDPRESS

TRADUCIR WORDPRESS

TRADUCIR WORDPRESS

CONTAR PALABRAS WEB

CONTAR PALABRAS WEB

TRADUCCIÓN MAGENTO

TRADUCCIÓN MAGENTO

TRADUCCIONES GRATIS

TRADUCCIONES GRATIS

PRECIO TRADUCCIÓN WEB

PRECIO TRADUCCIÓN WEB

COMO TRADUCIR UNA WEB

COMO TRADUCIR UNA WEB

TRADUCIR WEB GOOGLE

TRADUCIR WEB GOOGLE

TRADUCCION XML

TRADUCCION XML